Los casos de cuentas de Google eliminadas por falsos positivos de CSAM se disparan en Reddit

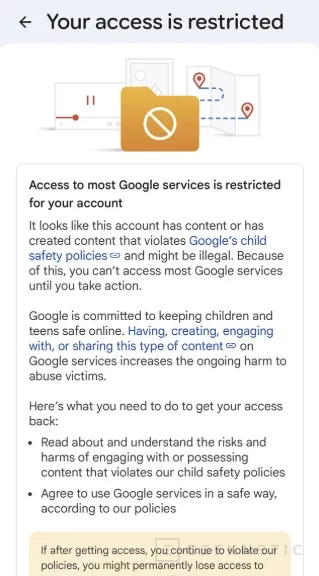

por Edgar OteroEl número de usuarios que reportan el cierre permanente de sus cuentas de Google por supuestas violaciones relacionadas con material de abuso sexual infantil (CSAM) está experimentando un aumento notable. Una búsqueda rápida en Reddit muestra decenas de casos recientes donde personas afirman haber perdido el acceso completo a Gmail, Drive, YouTube y otros servicios de Google tras sincronizar fotos familiares, imágenes médicas o incluso datasets de inteligencia artificial.

Si bien es imposible verificar cada testimonio individual en Reddit y debemos tratarlos con cautela, el volumen creciente de reportes resulta alarmante. La mayoría de estos casos parecen surgir tras sincronizaciones masivas que incluyen memes descargados, archivos personales donde aparecen los hijos del propietario de la cuenta o contenido completamente legal que el sistema de Google malinterpreta. Presuntamente, se trataría de falsos positivos del algoritmo PhotoDNA de Microsoft que Google utiliza para detectar este tipo de material.

El problema no es nuevo. En 2022, The New York Times documentó dos casos verificados de padres cuyas cuentas fueron cerradas permanentemente después de fotografiar los genitales de sus hijos pequeños por indicación médica. En San Francisco, un padre llamado Mark fotografió la zona genital inflamada de su hijo tras una solicitud de la enfermera de su pediatra para una consulta por videollamada durante la pandemia. Dos días después, su cuenta fue desactivada permanentemente. Perdió correos, contactos, documentación de los primeros años de vida de su hijo y su número de teléfono de Google Fi, lo que le bloqueó el acceso a otras cuentas digitales que dependían de códigos de seguridad enviados a ese número.

En Houston, otro padre perdió su cuenta tras fotografiar a su hijo por indicación de un pediatra para diagnosticar una infección. Las imágenes se sincronizaron automáticamente con Google Fotos y fueron enviadas a su esposa mediante Google Messenger. La pareja estaba en pleno proceso de compra de una vivienda cuando la cuenta fue desactivada, complicando aún más la situación. En ambos casos, la policía investigó y determinó que no se había cometido ningún delito, pero Google mantuvo las cuentas cerradas a pesar de las apelaciones con informes policiales que certificaban la inocencia de los usuarios.

Un caso reciente en Reddit involucra a un desarrollador que perdió su cuenta por utilizar un dataset de entrenamiento de IA para desarrollar Punge, una aplicación de detección de contenido NSFW en el dispositivo. La imagen marcada resultó ser simplemente una pierna de mujer. Otro usuario reportó la pérdida de acceso tras usar el generador de imágenes Nano Banana de Google para recrear una tendencia viral de TikTok donde las personas se abrazaban con versiones más jóvenes de sí mismas. Ninguno de estos casos involucra CSAM real.

La nube es cómoda, pero nunca olvides que es el ordenador de otro

Más allá de la veracidad individual de cada caso reportado en Reddit, la situación plantea una reflexión importante sobre la dependencia de servicios en la nube. Google, en su declaración oficial, asegura que "revisores humanos también juegan un papel crítico para confirmar coincidencias y contenido descubierto mediante IA". Sin embargo, los casos documentados sugieren que estos controles fallan con más frecuencia de lo deseable.

La recomendación es clara: mantén copias de seguridad locales de todo lo que consideres importante en Google Drive, Fotos o cualquier otro servicio en la nube. La nube es conveniente y útil, pero siempre será el ordenador de otra persona, sujeto a sus algoritmos, políticas y errores. Ningún usuario debería perder años de correos electrónicos, fotos familiares, documentos de trabajo o acceso a servicios críticos por un falso positivo sin posibilidad real de apelación. Tener el control de tus propios datos mediante almacenamiento local y copias regulares es la única forma de garantizar que un error algorítmico no borre tu vida digital de la noche a la mañana.

La paradoja de Apple: demandado por el problema contrario

La situación con Google contrasta de forma irónica con la demanda que Virginia Occidental acaba de presentar contra Apple. Mientras Google enfrenta críticas por escanear demasiado y generar falsos positivos que destruyen cuentas de usuarios inocentes, Apple está siendo demandada por no escanear lo suficiente, permitiendo supuestamente que iCloud se convierta en una plataforma segura para material ilegal.

Apple abandonó el desarrollo de su sistema de detección de CSAM en 2022 tras una fuerte reacción de defensores de la privacidad que argumentaban que cualquier puerta trasera, incluso con buenas intenciones, podría ser abusada. Ahora enfrenta consecuencias legales por esa decisión. Entre ambos extremos, el dilema técnico y ético permanece sin resolver: ¿existe alguna solución que equilibre efectivamente la protección infantil con la privacidad y que no destruya vidas digitales de usuarios inocentes en el proceso?

Fin del Artículo. ¡Cuéntanos algo en los Comentarios!